1) Neural Network

행렬을 곱하는 변환을 하며 활성화함수를 씌워 비선형 변환을 하며 함수에 근사하는 모델

함수??

이미지를 분류하고자 하면 그거 자체를 함수로 볼 수 있다.

가장 간단한 예

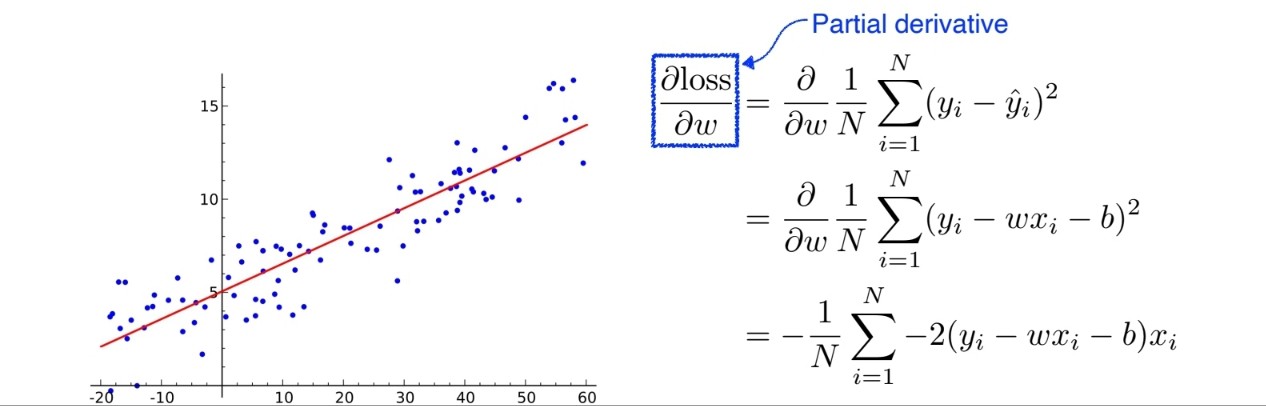

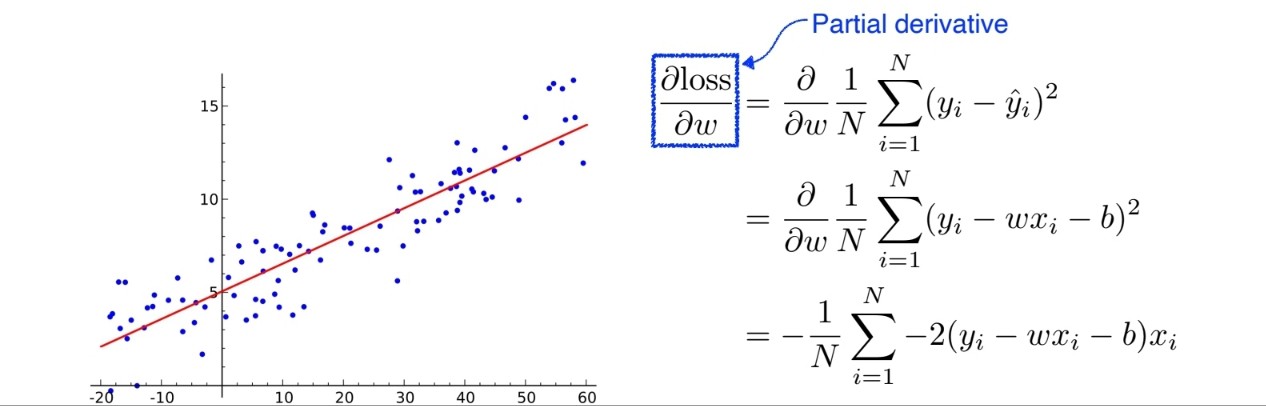

-> Linear Regression

여기서 이 모델의 식은 y = wx +b 로 정의된다.

이때 가장 근사한 w와 b를 찾으면 되는 문제이다.

Loss 는 MSE 를 사용하였다.

loss 가 최소가 되는 값을 구해야한다. 이 때 미분을 이용한다.

loss에 대한 미분 값을 구해 Learning Rate에 곱해 Update를 시켜주며 근사한 w와 b를 찾을 수 있다.

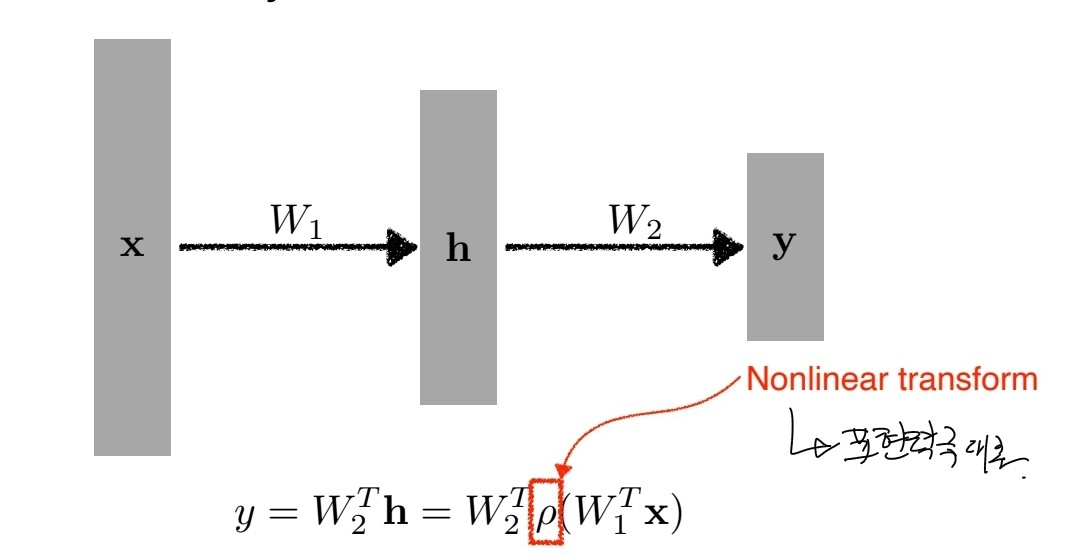

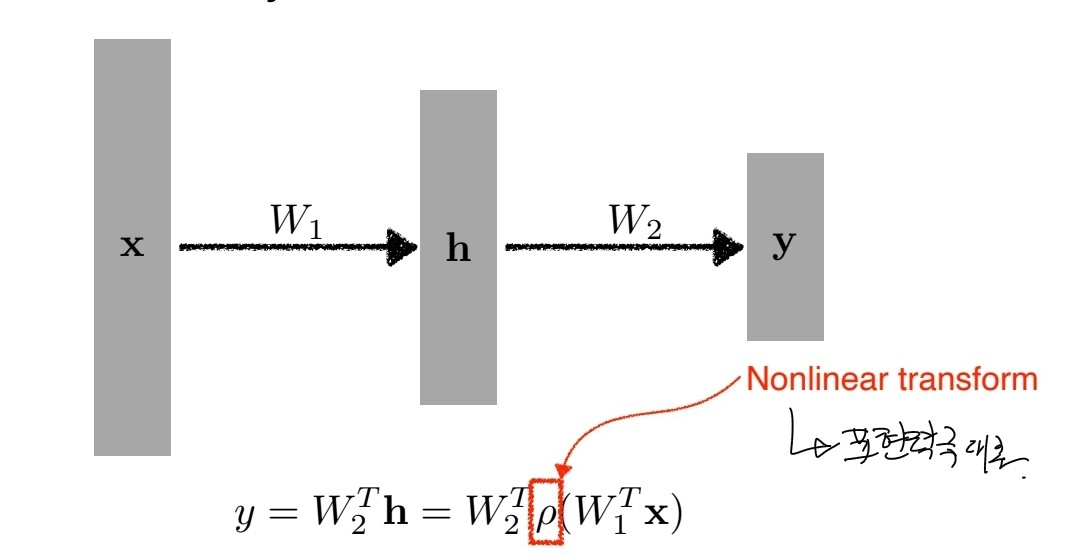

만약 층을 깊게 쌓고 싶다면???

이렇게 weight를 2번 곱하기 만 하면 의미가 없다. 한 번 곱한것이랑 차이가 없기 때문이다.

따라서 아래그림처럼 활성화함수를 적용시켜 비선형적으로 만든다. 이는 표현력을 극대화할 수 있다.

MLP(Multi Layer Perceptron)

입력이 있을 때 affine transformations를 통해 히든 벡터가 나오고 hidden layer에서 다시 affine transformations 1단짜리 hidden layer가 있는 network를 보통 MLP라 부른다. hidden layer를 깊게 쌓을 수도 있다.

'AI > Deep Learning' 카테고리의 다른 글

| Generative Model (Autoregressive model) (0) | 2023.03.24 |

|---|---|

| Optimizer (0) | 2023.03.24 |

| Transformer (0) | 2023.03.23 |

| RNN(Recurrent Neural Networks) (0) | 2023.03.22 |

| 0. Deep Learning 개요 (0) | 2023.03.20 |

1) Neural Network

행렬을 곱하는 변환을 하며 활성화함수를 씌워 비선형 변환을 하며 함수에 근사하는 모델

함수??

이미지를 분류하고자 하면 그거 자체를 함수로 볼 수 있다.

가장 간단한 예

-> Linear Regression

여기서 이 모델의 식은 y = wx +b 로 정의된다.

이때 가장 근사한 w와 b를 찾으면 되는 문제이다.

Loss 는 MSE 를 사용하였다.

loss 가 최소가 되는 값을 구해야한다. 이 때 미분을 이용한다.

loss에 대한 미분 값을 구해 Learning Rate에 곱해 Update를 시켜주며 근사한 w와 b를 찾을 수 있다.

만약 층을 깊게 쌓고 싶다면???

이렇게 weight를 2번 곱하기 만 하면 의미가 없다. 한 번 곱한것이랑 차이가 없기 때문이다.

따라서 아래그림처럼 활성화함수를 적용시켜 비선형적으로 만든다. 이는 표현력을 극대화할 수 있다.

MLP(Multi Layer Perceptron)

입력이 있을 때 affine transformations를 통해 히든 벡터가 나오고 hidden layer에서 다시 affine transformations 1단짜리 hidden layer가 있는 network를 보통 MLP라 부른다. hidden layer를 깊게 쌓을 수도 있다.

'AI > Deep Learning' 카테고리의 다른 글

| Generative Model (Autoregressive model) (0) | 2023.03.24 |

|---|---|

| Optimizer (0) | 2023.03.24 |

| Transformer (0) | 2023.03.23 |

| RNN(Recurrent Neural Networks) (0) | 2023.03.22 |

| 0. Deep Learning 개요 (0) | 2023.03.20 |